100G以太网的发展与现状

早在2006年下半年,IEEE就成立了一个名为HSSG(Higher Speed Study Group)的工作组,这个工作组的目标就是要研究制定下一代高速以太网100G的标准。2010年是以太网技术领域里最具里程碑意义的一年,6月17日IEEE正式批准了IEEE 802.3ba标准,这标志着40G/100G以太网的商用道路正式启程了。事实上,早在2009年,Cisco、Juniper、Huawei等就纷纷推出100G以太网的产品平台和线卡。在标准尚未发布之前就发布对应的产品,这也从另一个侧面印证了市场对下一代高速以太网的旺盛需求以及业界的热情。

在标准之路上IEEE并不孤单,有多个光通信标准组织也在积极制定相关规范,涵盖40G/100G器件、光模块、OTN开销处理、系统设备等领域。我们已经看到,随着相关标准的正式发布,整个产业链的热情已被彻底激活,从2010年下半年开始,商用集成芯片供应商、设备制造商明显加快了在40G/100G以太网上的开发节奏,各行各业的用户也加快了对100G以太网的部署。尤其是最近两年,伴随着云计算、大数据的蓬勃发展,进一步推动40G/100G以太网技术与产品成为业界的热点。

100G以太网在云中的部署趋势

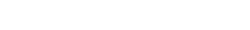

云计算将海量的计算与存储资源集中在一起,通过基础网络将这些资源连接起来,基于虚拟化、自动调度、按需申请、动态回收等技术,使得云计算的用户可以好像使用水、电等公共基础设施一样使用云中的业务与应用。显而易见,云中的数据中心是业务与应用的大集中之地,所有用户的访问流量(很形象的,我们称其为“南北向流量”)都将汇集到这里来;同时,鉴于数据中心不同功能模块的设计与分布,在这些功能模块之间也流动着海量的流量(类似的,我们称其为“东西向流量”)。如下图所示:

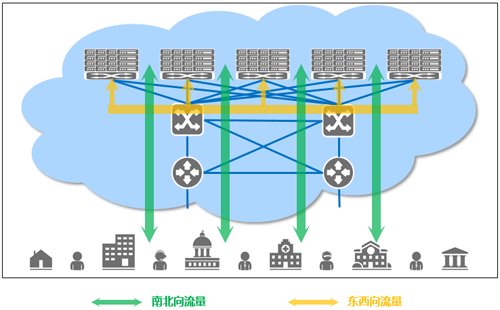

毋庸置疑的是,这些南北向流量和东西向流量对带宽有着超高的需求,对于中大规模的云计算环境来说,100G只是起步需求。在100G以太网技术商用之前,承载这些流量的通道,一般是利用多链路捆绑技术由多条10G以太网链路捆绑而成。如下图所示:

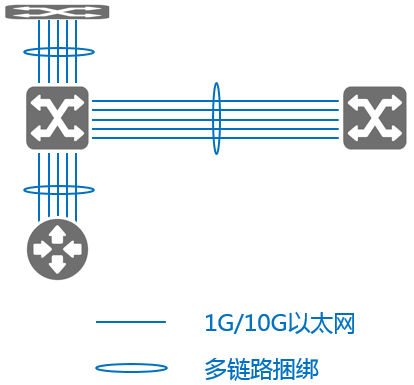

100G以太网技术的成功商用,使得如上南北/东西向流量的通道部署问题大大简化:云计算环境的运营者不需要再采用复杂的链路捆绑技术,而是用简单的一条链路解决以前几条甚至十几条链路才能解决的问题。如下图所示:

今天,在云计算环境中部署100G以太网已经成为不可逆转的趋势。未来,为云中南北向流量和东西向流量提供超高带宽,将是100G以太网的主战场之一。

在云中部署ADC

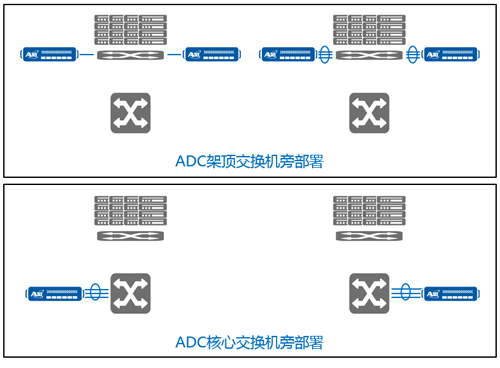

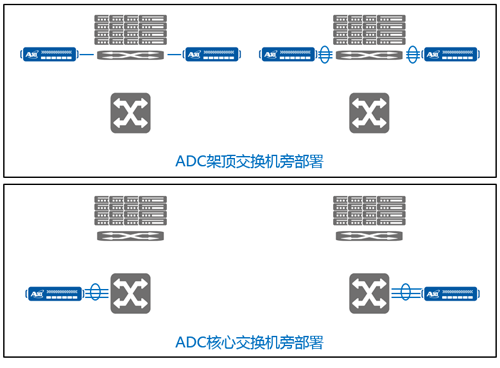

云中汇集了大量的业务与应用,ADC作为控制业务和应用交付的逻辑单元,在云计算环境中的部署是坚决不可或缺的。简单来看,ADC在云中的部署有如下两种方案:或者通过捆绑链路部署在核心交换机旁边,或者通过10G或者更低速链路部署在架顶交换机旁边。如下图所示:

1. ADC架顶交换机旁部署

2. ADC核心交换机旁部署

显而易见,以上两种部署方式都有其不可避免的缺点:

• 架顶交换机旁的部署方案,虽然对链路带宽和ADC处理容量要求不高,但却要求部署多套ADC,无形中大幅增加了云运营者的成本;

• 核心交换机旁的部署方案,虽然解决了上述方案的问题,但是为了在核心交换机和ADC之间提供高速通道,却必须在二者之间启用多链路捆绑,从而将网络及业务的运维复杂度提升了一个数量级。

ADC支持100G以太网可以有效优化网络、简化运维

100G以太网的成功商用,使得在云中部署ADC时面临的如上问题迎刃而解。但在进一步讨论这个问题之前,我们需要先仔细看看,前100G时代在云中部署ADC,到底面临着什么样的挑战。

因为传统的ADC不支持高速接口,并且整机处理容量有限,一个自然而然的思路是,将ADC部署在架顶交换机的旁边,一套ADC处理一个机架内业务的分发(或多套ADC,视该机架所承载的业务量的大小而定)。这样的方案有两个问题:

• 一来,需要部署多套ADC设备,使得云计算运营者的TCO大幅增加(设备成本的增加,以及随之而来的电力消耗、运维成本等的增加);

• 二来,因为传统ADC不支持高速以太网,在单机架承载业务量超过10G的部署场合,仍然需要采用多链路捆绑技术为ADC和架顶交换机之间的互连提供“高速”通道,所以也仍然面临着网络及业务的运维复杂度提升的苦恼。

另一个思路是,将处理性能超高的ADC部署在核心交换机旁边,为运行在所有机架上的业务提供分发服务。这样的部署方案在一定程度上优于上述方案,但是ADC与核心交换机之间的高速通道仍然是一个问题。在传统时代,多链路捆绑技术不失为一个构建高速通道的好方法,但这个好方法背后也隐藏着无法解决的问题。单单从物理带宽上看,多链路捆绑技术似乎达到了实现更高速物理接口的目的,但实际上,这样的链路聚合存在诸多问题。

• 首先,数据流在多个物理端口之间要进行链路选择(多采用HASH算法),这就使得各个链路的负载可能存在很大的差异,而一旦出现链路负载的不均衡,势必会降低聚合链路的有效带宽。实际上,不同的流量模型非常可能会导致负载不均衡的加剧和恶化,从而大大降低链路的可用带宽。

• 另外一方面,采用多个物理端口捆绑的方式来提高上行的接口带宽,由于接口数量多,所以自然而然就会导致在接口上连接的光纤数量大大增加(100G接口只需1对光纤,10*10G则需要10对光纤,1:10)。光纤数量的增加,不仅仅给机房部署、设备维护带来更大麻烦,更为重要的是,会对链路保护和倒换造成极大的困难,甚至无法实现,这对于可靠性要求极高的应用场景来说,成为一个致命的缺陷。

• 还有,多端口捆绑也会给用户在网络基础建设方面带来更多的投入,这包括占用路由器、交换机上更多端口(或槽位),购买更多的光模块、光纤,租用更多的低速端口链路等等。

从以上分析来看,解决这个问题的关键点在于:ADC具备大容量的业务处理性能,支持超高的虚拟化特性,并且支持100G以太网。其中,支持100G以太网可以说是这一解决方案的坚实基础,使得这个“高性能+虚拟化+高速通道”的方案不再是空中楼阁。

如上图所示,具备大容量业务处理性能的ADC,通过100G以太网部署在核心交换机旁边,并且通过虚拟化能力,同时为上千个用户(业务/租户)提供业务交付功能。这一方案,在有效降低云运营者的TCO、网络与业务的运维复杂度的同时,为云中业务提供完善的、无损的业务交付。

A10 Networks率先支持100G以太网

作为全球应用网络的领导者,A10 Networks始终以技术创新和满足用户需求为宗旨,其在2014年4月推出的新款ADC Thunder6630/6630S,在业界率先支持100G以太网,开启了ADC行业的“百G时代”。此外,其配备了灵活的10GbE/40GbE/100GbE接口和24核Xeon CPUs,可实现150G的超高业务处理性能、2.23亿次的并发处理能力、710万次的每秒新建处理能力、同时支持上千租户的虚拟化能力,能够满足客户对数据中心日益严苛的扩展及安全需求,成为了大中型云提供商构建其业务交付系统的不二之选!

Thunder 6630/6630S——首款100GB以太网接口的应用交付控制器

我们一直都在努力坚持原创.......请不要一声不吭,就悄悄拿走。

我原创,你原创,我们的内容世界才会更加精彩!

【所有原创内容版权均属TechTarget,欢迎大家转发分享。但未经授权,严禁任何媒体(平面媒体、网络媒体、自媒体等)以及微信公众号复制、转载、摘编或以其他方式进行使用。】

微信公众号

TechTarget

官方微博

TechTarget中国

相关推荐

-

瞻博网络捆绑Contrail Networking、OpenStack

瞻博网络捆绑了自身的软件与合作伙伴Red Hat的软件,以提供专注于开源的平台,服务提供商可利用该平台来在网络 […]

-

三年成为独角兽,数梦工场做对了什么?

2018年3月12日,杭州创业创新领域年度盛事——2018第二届万物生长大会在钱塘江畔举行。大会对2017年度 […]

-

中国电信与华为成立商业联合创新中心

中国电信与华为共同宣布成立商业联合创新中心(以下简称BJIC),合力打造差异化的创新产品与解决方案,为用户带来 […]

-

拥有可视性:让云的作用发挥最大化

云改变了企业的业务模式,让网络环境变得越来越碎片化,也带来了更多风险。因而在云环境中拥有可视性尤为重要……